1. Nguồn gốc của ý tưởng MoE

Khái niệm MoE xuất hiện lần đầu năm 1991, qua công trình “Adaptive Mixtures of Local Experts” của Geoffrey Hinton, Robert Jacobs và Michael Jordan. Mục tiêu ban đầu tương tự ensemble learning: thay vì một mô hình “ôm đồm” mọi việc, hãy kết hợp nhiều mô hình nhỏ, mỗi mô hình xử lý một phần của vấn đề.

Ý tưởng này là dạng “chia để trị”: bài toán lớn được tách thành nhiều bài toán con, giao cho đúng người giỏi nhất xử lý. Gating network đóng vai trò “người điều phối”, định tuyến dữ liệu tới đúng expert.

Tuy nhiên, trong gần 30 năm sau đó, MoE ít được ứng dụng rộng rãi do hạn chế về phần cứng, dữ liệu và hiệu quả so với các mô hình nơ-ron dense (tất cả tham số đều hoạt động cùng lúc). MoE chỉ thật sự trở lại khi Transformer và LLM ra đời. Năm 2017, Google công bố “Outrageously Large Neural Networks”, cho thấy MoE có thể giúp mở rộng mô hình khổng lồ mà vẫn tối ưu tài nguyên.

2. Nguyên lý hoạt động

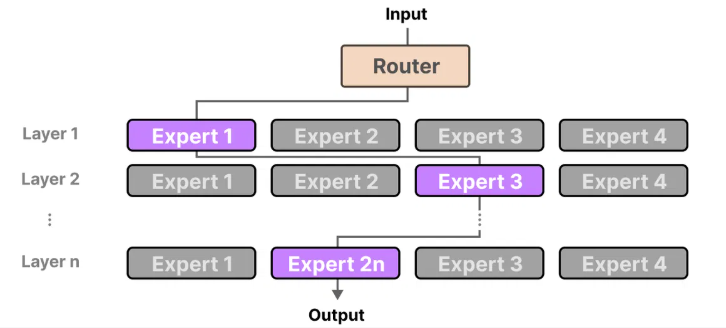

Một kiến trúc MoE gồm hai thành phần chính:

-

Các Expert – Nhiều mạng nơ-ron nhỏ, mỗi cái chuyên xử lý một nhóm dữ liệu hoặc nhiệm vụ riêng (ví dụ: expert về Python code, expert về viết văn).

-

Gating Network (Router) – Mạng nơ-ron nhỏ quyết định token đầu vào nên gửi tới expert nào.

Ưu điểm: Tổng số tham số của MoE có thể cực lớn, nhưng khi xử lý, chỉ một vài expert được kích hoạt, nên tốc độ tương đương mô hình nhỏ.

💡 Ví dụ thực tế:

Dense model giống như họp toàn bộ ban giám đốc công ty để giải quyết mọi vấn đề, dù nhiều người chẳng liên quan.

MoE giống như có thư ký thông minh: vấn đề về tài chính sẽ chỉ mời Giám đốc Tài chính, vấn đề kỹ thuật sẽ chỉ mời Giám đốc Công nghệ.

3. MoE trong Transformer

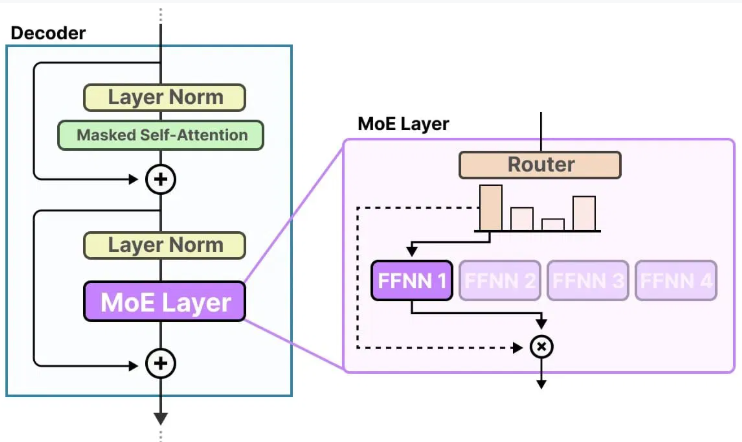

Trong Transformer, MoE thường thay thế Feed-Forward Network (FFN) ở một số layer.

Ví dụ: Mixtral 8x7B – mỗi layer MoE có 8 experts, nhưng mỗi token chỉ được xử lý bởi 2 expert được chọn (top-k = 2).

4. Cơ chế bên trong một MoE Layer

Giả sử ta có vector đầu vào x:

Tính điểm (Scores)

Gating Network có ma trận trọng số Wg. Nhân x với Wg → thu được vector logits, mỗi phần tử tương ứng với một expert.

Softmax

Biến scores thành xác suất chọn expert:

Top-k Routing

Chọn ra k experts có điểm cao nhất (ví dụ k=2).

Điều này cho phép kết hợp nhiều chuyên môn nếu câu hỏi phức tạp.

Kết hợp kết quả

Output cuối cùng = tổng đầu ra của các expert được chọn, nhân với trọng số từ G(x).

Trong đó Ei(x) là kết quả expert i xử lý x.

5. Kết luận

MoE là giải pháp “chia việc” cực hiệu quả, giúp mô hình:

Ngày nay, nhiều LLM hiện đại như GPT, Mixtral, DeepSeek, Google Gemini đều áp dụng MoE để đạt hiệu năng vượt trội, vừa mạnh vừa tiết kiệm.